All posts under computer

Die Computer-Maus bekommt eine Ablöse

Künstliche Intelligenz und die Angst vor ihr

Alpha Go & Co.: So schnell lernt die Google-KI

Kann man Trojaner impfen, um Cyber-Attacken zu verhindern?

Chance oder Gefahr? Forscher und Ethiker müssen bei der Schnittstellentechnologie zusammenarbeiten

Alte Besen kehren schlecht: Wie gefährdet sind veraltete Computersysteme im öffentlichen Dienst?

FollowUs – Die Netzpiloten-Tipps aus Blogs & Mags

FollowUs – Die Netzpiloten-Tipps aus Blogs & Mags

FollowUs – Die Netzpiloten-Tipps aus Blogs & Mags

Leben wir in der Matrix? Was Elon Musk glaubt – und was wirklich dran sein könnte

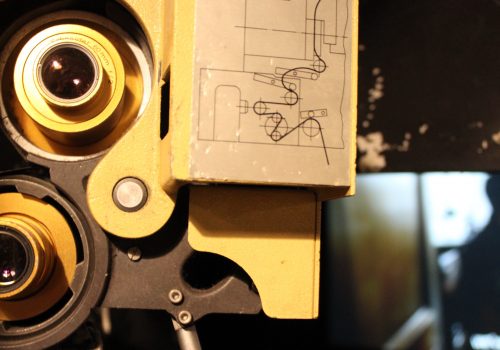

Von Zelluloid zu Gigabyte – Digitalisierung im Kino

Wissen, wann man abwirft: KI schlägt weltbesten Pokerspieler

Die neue Phase der Cybersicherheit: Cyberabschreckung

10 Jahre danach: Wo uns das iPhone weitergebracht hat – und wo nicht.

Wie man mit Spieletechnologie Tatorte hacken kann

Wenn Roboter fühlen lernen

Superschnelle „Quantencomputer“ – Das Ende der sicheren Verschlüsselung?

Das sehen Hunde, wenn sie fernsehen

Augmented Reality: Woher weiß ein Computer, wo wir hinschauen?

FollowUs – Die Netzpiloten-Tipps aus Blogs & Mags

Law and Order and Robots: Wie Geschworene den Tatort virtuell besichtigen können

FollowUs – Die Netzpiloten-Tipps aus Blogs & Mags

Nach dem NSA-Hack: Cyber-Sicherheit in einer verletzlicheren Welt

Macht die Arbeit am Computer krank?

Von lebenden Computern zu Nanorobotern: Wie wir uns die DNA über die Genetik hinaus zu Nutze machen.

FollowUs – Die Netzpiloten-Tipps aus Blogs & Mags

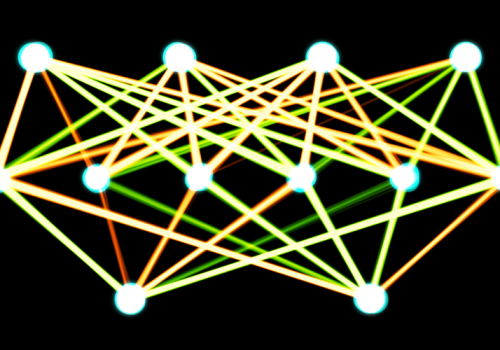

Unternehmen öffnen sich der Idee des Deep Learning

Würden Sie Ihre Atomraketen einer Diskette anvertrauen?

Können wir Politiker durch Roboter ersetzen?

Warum uns das Internet nicht klüger macht

Süchtig nach sozialen Medien? Wie wäre es mit E-Fasten?

Ransomware-Boom zeigt Notwendigkeit von Backups auf

Die Kunst auf dem Daten-Highway

Was ist Denken – und wird eine Maschine je dazu in der Lage sein?

Über den Antrieb der Künstlichen Intelligenz von Google und Facebook

Warum man nie ein Gehirn in die Cloud hochladen kann

Zurückgeblättert: Abenteuer Computer im Jahr 1995

Wie Computer die Wissenschaft kaputt machen

SSD vs. HDD – Aufbruch in eine neue Speicherära

5 Lesetipps für den 7. Juli

In unseren Lesetipps geht es heute um die neuen Wege des Journalismus, Quantencomputer, Überwachung, sowie das Facebook-Experiment und Streamingdienste. Ergänzungen erwünscht. FACEBOOK: W&V: Psycho-Experiment könnte Folgen für Facebook haben: Facebook steht erneut im Fokus von Datenschutz-Aktivisten. Nachdem vor kurzem bekannt wurde, dass Facebook im Jahre 2012 mit einem Test das[…]

Die Software als Interpret

Or Be Programmed

Der österreichische Schriftsteller Oskar Kokoschka sagte, dass ihm aus der Schulzeit nur seine Bildungslücken in Erinnerung geblieben sind. Ähnlich wird es wohl einmal den Kindern von Wolfgang Lünenbürger-Reidenbach gehen, die in einer zunehmend digitalisierten Gesellschaft leben werden, ohne die notwendige Ausbildung bekommen zu haben. Informatikunterricht. Gab es schon in den[…]

„IT‘s APP2you“: Wichtige Einblicke in die IT-Branche

Der Ideenwettbewerb „IT‘s APP2you“ hilft Schülern eine funktionsfähige Android-App zu entwickeln, um ihnen so die Vorzüge von IT-Berufen näher zu bringen. Es ist in Deutschland nicht nur an der Theodor Storm Schule in Husum, die „Netzpiloten“-Kolumnist Nico Lumma in seinem Beitrag „Das Digitale macht Schule anders“ beschreibt, an der Regel,[…]

Die 10 Gebote, des mündigen Anwenders

Das Digitale macht Schule anders

In seiner Kolumne beschäftigt sich Nico Lumma mit dem Medienwandel und Kompetenzen die damit einhergehen. Nicht nur im Beruf, sondern auch in der Schule und Familie. In seinem Kolumnen-Debüt spricht er von Medienverboten auf dem Schulgelände und der Herausforderung der digitalen Gesellschaft, das Konzept des mündigen Bürgers so zu adaptieren, dass es nicht bei der passiven Mediennutzung stehen bleibt.

Videotipp: TED-Vortrag – Why machines need people

In diesem Vortrag geht es um Menschen und ihre Maschinen sowie um die gegenseitigen Abhängigkeiten, zufällig auch interessant wegen des Themas künstliche Intelligenz…

Immer Ärger um den PC: Kinder finden kein Ende

Katrin Viertel von medienlotse.com beantwortet Fragen rund ums Thema Erziehung und digitale Medien. Heute geht es um Kinder, die es einfach nicht schaffen, den Computer auch mal auszuschalten. Frage: Meine Tochter (12) darf unseren Computer täglich eine Stunde benutzen, auch allein. Meist spielt sie Sims oder ist mit ihren Freundinnen[…]

„Das Rad des Wissens und des Imaginären“

Anläßlich des neuen Buches über die Zukunft desselben treten die beiden ausgewiesenen bibliophilen 80jährigen Druckerschwärzesüchtigen Umberto Eco und der Drehbuchautor Jean-Claude Carrière an, um dem Journalisten de Tonnac alles über Vergangenheit, Wirkung und Zukunft des Buches zu erklären. Ähnlich wie die positiven Stimmen der vier Energieweisen aus dem Abendland zur[…]

CommonCraft: Computer Hardware in Plain English

Die Macher der Commoncraft-Show erklären in ihrem neuesten Video „Computer Hardware in plain English“. Wie immer sehenswert, gut gemacht, informativ und zum weiterempfehlen.

![Orb of power (adapted) (Image by Ramón Salinero [CC0 Public Domain] via Unsplash)](https://www.netzpiloten.de/wp-content/uploads/2018/01/Orb-of-power-adapted-Image-by-Ramón-Salinero-CC0-Public-Domain-via-Unsplash-500x350.jpg)

![P2121011 (adapted) (Image by Strelban [CC0 Public Domain] via flickr)](https://www.netzpiloten.de/wp-content/uploads/2017/12/P2121011-adapted-Image-by-Strelban-CC0-Public-Domain-via-flickr-500x350.jpg)

![Neourban, Laptop, Hardware (adapted) (Image by markusspiske [CC0 Public Domain] via pixabay)](https://www.netzpiloten.de/wp-content/uploads/2017/10/Neourban-Laptop-Hardware-adapted-Image-by-markusspiske-CC0-Public-Domain-via-pixabay-500x350.jpg)

![Brain (Image by HypnoArt [CC0 Public Domain], via Pixabay](https://www.netzpiloten.de/wp-content/uploads/2017/06/Brain-Image-by-HypnoArt-CC0-Public-Domain-via-Pixabay-500x350.jpg)

![Poker (adapted) (Image by Images Money [CC BY 2.0] via flickr)](https://www.netzpiloten.de/wp-content/uploads/2017/02/Poker-adapted-Image-by-Images-Money-CC-BY-2.0-via-flickr-500x350.jpg)

![konsole(image by quakeboy[CC0 Public Domain] via Pixabay)](https://www.netzpiloten.de/wp-content/uploads/2016/11/konsole.jpg-e1478078780148-500x350.jpg)

![Coding (image by negativespace.co [CC0 Public Domain] via Pexels](https://www.netzpiloten.de/wp-content/uploads/2016/09/Coding-image-by-negativespace.co-CC0-Public-Domain-via-Pexels-500x350.jpg)

![hund(image by lightstargod[CC0 Public Domain] via Pixabay)](https://www.netzpiloten.de/wp-content/uploads/2016/09/Hund-1-e1473833944483-500x350.jpg)

![Binary code (adapted) (Image by Christiaan Colen [CC BY-SA 2.0] via flickr)](https://www.netzpiloten.de/wp-content/uploads/2016/08/Binary-code-adapted-Image-by-Christiaan-Colen-CC-BY-SA-2.0-via-flickr-500x350.jpg)

![startup (image by StartupStockPhotos[CC BY 1.0] via Pixabay](https://www.netzpiloten.de/wp-content/uploads/2016/08/startup-image-by-StartupStockPhotosCC-BY-1.0-via-Pixabay-500x350.jpg)

![DNA (Image by PublicDomainPictures [CC0Public Domain]) via Pixarbay](https://www.netzpiloten.de/wp-content/uploads/2016/06/DNA-Image-by-PublicDomainPictures-CC0Public-Domain-via-Pixarbay-500x350.png)

![Exercise Plays Vital Role Maintaining Brain Health (adapted) (Image by A Health Blog [CC by 2.0] via flickr)](https://www.netzpiloten.de/wp-content/uploads/2016/06/Exercise-Plays-Vital-Role-Maintaining-Brain-Health-adapted-Image-by-A-Health-Blog-CC-by-2.0-via-flickr-500x350.jpg)

![Isolated Discs (Image by PublicDomainPictures [CC0 Public Domain], via Pixabay)_](https://www.netzpiloten.de/wp-content/uploads/2016/06/Isolated-Discs-Image-by-PublicDomainPictures-CC0-Public-Domain-via-Pixabay_-500x350.jpg)

![Roboter (Image by geralt [CC0 Public Domain] via pixabay)](https://www.netzpiloten.de/wp-content/uploads/2016/04/Roboter-Image-by-geralt-CC0-Public-Domain-via-pixabay-500x350.jpg)

![Volunteer Duty Psychology Testing (adapted) (Image by Tim Sheerman-Chase [CC BY 2.0] via flickr)](https://www.netzpiloten.de/wp-content/uploads/2016/04/Volunteer-Duty-Psychology-Testing-adapted-Image-by-Tim-Sheerman-Chase-CC-BY-2.0-via-flickr--500x350.jpg)

![Text On The Beach (adapted) (Image by Pete [Public Domain Mark 1.0] via Flickr](https://www.netzpiloten.de/wp-content/uploads/2016/04/Text-On-The-Beach-adapted-Image-by-Pete-Public-Domain-Mark-1.0-via-Flickr-500x350.jpg)

![Schloss (image by stevebp [CC0 Public Domain] via Pixabay)new](https://www.netzpiloten.de/wp-content/uploads/2016/03/Schloss-image-by-stevebp-CC0-Public-Domain-via-Pixabaynew-500x350.jpg)

![The Whitechapel Gallery (adapted) (Image by Herry Lawford [CC BY 2.0] via flickr)](https://www.netzpiloten.de/wp-content/uploads/2016/02/The-Whitechapel-Gallery-adapted-Image-by-Herry-Lawford-CC-BY-2.0-via-flickr-500x350.jpg)

![Thinking (adapted) (Image by Wade M [CC BY-SA 2.0] via flickr)](https://www.netzpiloten.de/wp-content/uploads/2016/01/Thinking-adapted-Image-by-Wade-M-CC-BY-SA-2.0-via-flickr-500x350.jpg)

![Exercise Plays Vital Role Maintaining Brain Health (adapted) (Image by A Health Blog [CC BY-SA 2.0] via flickr)](https://www.netzpiloten.de/wp-content/uploads/2016/01/Exercise-Plays-Vital-Role-Maintaining-Brain-Health-adapted-Image-by-A-Health-Blog-CC-BY-SA-2.0-via-flickr-500x350.jpg)

![19941995 Flatland BBS Menu Screen (adapted) (Image by Tim Patterson Folgen [CC BY-SA 2.0] via flickr)](https://www.netzpiloten.de/wp-content/uploads/2015/12/19941995-Flatland-BBS-Menu-Screen-adapted-Image-by-Tim-Patterson-Folgen-CC-BY-SA-2.0-via-flickr-500x350.jpg)

![Historic Computer (image by U.S. Army Photo [CC0 Public Domain])](https://www.netzpiloten.de/wp-content/uploads/2015/11/Historic-Computer-image-by-U.S.-Army-Photo-CC0-Public-Domain-500x350.jpg)

![Les Robots-Music (adapted) (Image by Sascha Pohflepp [CC BY 2.0] via Flickr)](https://www.netzpiloten.de/wp-content/uploads/2016/06/Les-Robots-Music-adapted-Image-by-Sascha-Pohflepp-CC-BY-20-via-Flickr-500x350.jpg)