All posts under Algorithmus

“Mobile Recruiting” – mit einem Wisch zum Traumjob?

„Für Originalität muss man die Welt wahrnehmen“: Technikphilosoph Mads Pankow im Interview

Vero – Hype um die neue Social Media App

FollowUs – Die Netzpiloten-Tipps aus Blogs & Mags

FollowUs – Die Netzpiloten-Tipps aus Blogs & Mags

FollowUs – Die Netzpiloten-Tipps aus Blogs & Mags

Diese Technologie verhindert die Übertragung von Morden bei Facebook Live

Künstliche Intelligenz: Verstehen, wie Maschinen lernen

Brains vs. Robots: Der Aufstieg der Roboter ist nicht aufzuhalten

Fabian Westerheide über Künstliche Intelligenz

FollowUs – Die Netzpiloten-Tipps aus Blogs & Mags

Wie der Google-Algorithmus und seine Suchergebnisse zu Verschwörungstheorien führen kann

Analog trifft Digital: Per App zum Gesprächspartner beim Mittagessen

FollowUs – Die Netzpiloten-Tipps aus Blogs & Mags

Algorithmen verändern das Geschäft

Kann uns AlphaGo bei der Bewältigung des Klimawandels helfen?

#EsIstVorbei: Schlussmachen im Zeitalter des Internets

5 Lesetipps für den 22. Januar

In unseren Lesetipps geht es heute um Polen, Periscope, Netflix, wie ein Algorithmus politische Reden schreibt und die Messenger der Zukunft. Ergänzungen erwünscht. POLEN Foreign Policy: Obama Is Poland’s Only Hope: Die neue polnische Regierung versucht mehr als zwei Dekaden demokratische Entwicklung in nur wenigen Wochen umzukehren. Und die Europäische Union[…]

5 Lesetipps für den 28. Dezember

In unseren heutigen Lesetipps geht es um Open Source, Smartphones in unserer Gesellschaft, Anonymität, Big Data und Algorithmen, sowie Doppelgänger. Ergänzungen erwünscht. OPEN SOURCE Wired: Open Source Software Went Nuclear This Year: Es ist der finale Satz von Cade Metz Artikel, der eine der wichtigsten Lektionen des Jahres in einfache Worte[…]

Wie Big Data vor Kreditkartenbetrug schützt

5 Lesetipps für den 8. Dezember

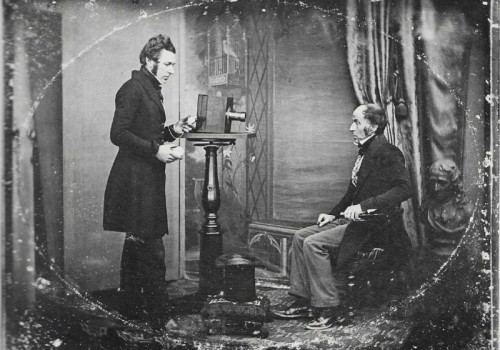

Ein Algorithmus analysiert Porträts eines Jahrhunderts

Wird Twitter durch „Moments“ menschlicher?

Maschinen für die glückliche Suche

CityBeat: Daten sollen helfen, News zu finden

Entscheidungsmacht von Algorithmen: Mensch versus Algorithmus

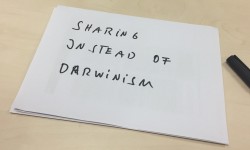

Datenschutz reloaded: Teilen statt Darwinismus?

5 Lesetipps für den 25. März

In unseren Lesetipps geht es heute um das Verhältnis der SPD zur Digitalisierung, einen Zweitmarkt für E-Books, Native Journalism, Algorithmen als Kunst und einen Überlebensratgeber für Künstler. Ergänzungen erwünscht. DIGITALISIERUNG der Freitag: Innere Sicherheit. Gerechtigkeit. Solidarität: Die SPD kommt beim Thema Digitalisierung nur schwer in die Gänge. Dabei müsste sie sich doch[…]

Algorithmus-Update: Facebook will mehr Twitter

OKCupid macht Nutzer zu Versuchskaninchen

5 Lesetipps für den 23. Juli

In unseren Lesetipps geht es heute um Algorithmen, das Recht auf Vergessen, Smart Home durch das Internet der Dinge, Big Data-Erzählungen und Robotik. Ergänzungen erwünscht. ALGORITHMEN MIT Center for Civic Media: Uncovering Algorithms: Um in einer datengetriebenen Gesellschaft frei und selbstbestimmt arbeiten zu können, muss das System hinter den Daten, die[…]

5 Lesetipps für den 17. Juli

In unseren Lesetipps geht es heute um die Faszination und Beliebtheit von Instagram, die Bedeutung von Algorithmen, Yahoos Suchmaschine und Filesharing. Ergänzungen erwünscht. INSTAGRAM W&V: „Instagram funktioniert als Werbeplattform sehr sehr gut“: Anfang des Jahres berichtete Instagram von 200 Millionen Nutzern. Nur wenige davon kommen aus Deutschland. Das Berliner Startup Brandnew[…]

Wenn der Algorithmus den Job vermittelt

Curation is King: Menschliche Expertise statt maschineller Algorithmus

5 Lesetipps für den 27. März

In unseren Lesetipps geht es heute um das Verbindunsgarrangement zwischen Netflix und Comcast, Algorithmen, Sprachen im Digitalen, die Geschichte hinter Oculus und Sexismus im Internet. Ergänzungen erwünscht. VERBINDUNGSARRANGEMENT HIIG: Ein sozialwissenschaftlicher Blick auf den Verbindungs-Deal zwischen Netflix und Comcast: Auf dem Blog des Humboldt Instituts für Internet und Gesellschaft setzt sich[…]

ShortRead: Facebook benachteiligt textbasierte Posts

Perettis Geheimwaffe bei BuzzFeed hat einen Namen: Ky Harlin

5 Lesetipps für den 12. Dezember

In unseren Lesetipps geht es um Algorithmen bestimmenden Journalismus, ein Obdachloser lernt eine App zu programmieren, der Smarty Ring, Markus Lanz und der Shitstorm sowie die Geschichte eines Selfie. Ergänzungen erwünscht. ALGORITHMUS Carta: Der Guardian setzt Roboter als Chefredakteur ein: Der Guardian setzt Roboter als Chefredakteur ein. Na ja, beinahe –[…]

Facebook: News Feed Ranking erstmals erläutert

Dem Algorithmus ein natürlicher Feind sein?

Es kam, wie es kommen musste. Der Algorithmus. Eine Handlungsvorschrift, die sequentiell, also nacheinander abgearbeitet wird, um ein Problem zu lösen bzw. eine Aufgabe zu erfüllen, wird zum Spielball der Dichter und Denker. Als Miriam Meckel darüber geschrieben hat – und nichts anderes fand als die fade recommendation engine aus[…]

Das könnte Ihnen auch gefallen!

Heute morgen habe ich beim surfen in der 3sat.Mediathek diesen Beitrag gefunden, der uns zeigt wie unsere Vorlieben beim Onlineshopping per Algorithmus ausgelesen und wiedergegeben werden. Nichts Neues denkt ihr? Ja, vielleicht. Wobei man neue Felder ansteuern will. Felder, die man eigentlich gar nicht für möglich halten würde – wie[…]

Google: Der Panda geht um

Wenn Google niest, fallen ganze Firmen wie Kartenhäuser in sich zusammen. Nach den USA und England kommt also nun Deutschland in den Genuss des neuen Updates in Googles Suchalgorithmus namens Panda 2.2. Das hatte Matt Cutts, der Leiter von des Webspam-Teams bei Google anläßlich der Konferenz SMX Advanced in Seattle[…]

![Blutbad (adapted) (Image by HannahJoe7 [CC0 Public Domain] via pixabay)](https://www.netzpiloten.de/wp-content/uploads/2017/05/Blutbad-adapted-Image-by-HannahJoe7-CC0-Public-Domain-via-pixabay-500x350.jpg)

![Roboter (adapted) (Image by jens kuu [CC BY 2.0] via flickr)](https://www.netzpiloten.de/wp-content/uploads/2017/03/Roboter-adapted-Image-by-jens-kuu-CC-BY-2.0-via-flickr-500x350.jpg)

![Arzt (adapted) (Image by tmeier1964 [CC0 Public Domain] via pixabay)](https://www.netzpiloten.de/wp-content/uploads/2017/03/Arzt-adapted-Image-by-tmeier1964-CC0-Public-Domain-via-pixabay-500x350.jpg)

![Neural (adapted) (Image by geralt [CC0 Public Domain] via pixabay)](https://www.netzpiloten.de/wp-content/uploads/2017/03/Neural-adapted-Image-by-geralt-CC0-Public-Domain-via-pixabay-500x350.jpg)

![anonymous-438427_1920 (Image by SplitShire [CC0 Public Domain], via pixabay](https://www.netzpiloten.de/wp-content/uploads/2017/01/anonymous-438427_1920-Image-by-SplitShire-CC0-Public-Domain-via-pixabay-500x350.jpg)

![Mathematics Explore April 24, 2013 #4 (at one time) (adapted) (Image by Tom Brown [CC BY 2.0] via Flickr)](https://www.netzpiloten.de/wp-content/uploads/2016/03/Mathematics-Explore-April-24-2013-4-at-one-time-adapted-Image-by-Tom-Brown-CC-BY-2.0-via-Flickr-500x350.jpg)

![Künstliche Intelligenz (image by 849356 [CC0 Public Domain] via Pixabay)new](https://www.netzpiloten.de/wp-content/uploads/2016/03/Künstliche-Intelligenz-image-by-849356-CC0-Public-Domain-via-Pixabaynew-500x350.jpg)

![Love (of technology) (adapted) (Image by Matthew G [CC BY 2.0] via flickr)](https://www.netzpiloten.de/wp-content/uploads/2016/01/Love-of-technology-adapted-Image-by-Matthew-G-CC-BY-2.0-via-flickr-500x350.png)

![Kreditkarte (Image by jarmoluk [CC0 Public Domain], via Pixabay)](https://www.netzpiloten.de/wp-content/uploads/2015/12/Kreditkarte-Image-by-jarmoluk-CC0-Public-Domain-via-Pixabay-500x350.jpg)

![Twitter Bird Logo Sketch, New (adapted) (Image by Shawn Campbell [CC BY 2.0] via Flickr)](https://www.netzpiloten.de/wp-content/uploads/2015/06/Twitter-Bird-Logo-Sketch-New-adapted-Image-by-Shawn-Campbell-CC-BY-2.0-via-Flickr-500x350.jpg)

![zettelkasten (adapted) (Image by Kai Schreiber [CC BY-SA 2.0] via Flickr)](https://www.netzpiloten.de/wp-content/uploads/2015/10/zettelkasten-adapted-Image-by-Kai-Schreiber-CC-BY-SA-2.0-via-Flickr-500x350.jpg)

![News (adapted) (Image by MIH83 [CC0 Public Domain] via Pixabay)](https://www.netzpiloten.de/wp-content/uploads/2015/06/News-adapted-Image-by-MIH83-CC0-Public-Domain-via-Pixabay-500x350.png)

![Algorithmus (Bild by geralt [CC0] via pixabay).jpg](https://www.netzpiloten.de/wp-content/uploads/2015/05/Algorithmus-Bild-by-geralt-CC0-via-pixabay-500x350.jpg)

![Twitter Facebook miteinander (Bild: LoboStudioHamburg [CC0 1.0], via Pixabay)](https://www.netzpiloten.de/wp-content/uploads/2014/09/facetwitter_250x137.jpg)

![Online romance (adapted) (Image by Don Hankins [CC BY 2.0] via Flickr)](https://www.netzpiloten.de/wp-content/uploads/2016/07/Online-romance-adapted-Image-by-Don-Hankins-CC-BY-20-via-Flickr-500x350.jpg)

![Business Baby Pointing (adapted) (Image by Paul Inkles [CC BY 2.0] via Flickr)](https://www.netzpiloten.de/wp-content/uploads/2017/01/Business-Baby-Pointing-adapted-Image-by-Paul-Inkles-CC-BY-20-via-Flickr-500x350.png)

![Facebook Favourites Menu (adapted) (Image by Mixy Lorenzo [CC BY 2.0] via Flickr)](https://www.netzpiloten.de/wp-content/uploads/2017/01/Facebook-Favourites-Menu-adapted-Image-by-Mixy-Lorenzo-CC-BY-20-via-Flickr-500x350.png)

![Newspapers (adapted) (Image by Laurel F [CC BY-SA 2.0] via Flickr]](https://www.netzpiloten.de/wp-content/uploads/2017/01/Newspapers-adapted-Image-by-Laurel-F-CC-BY-SA-20-via-Flickr-500x350.png)