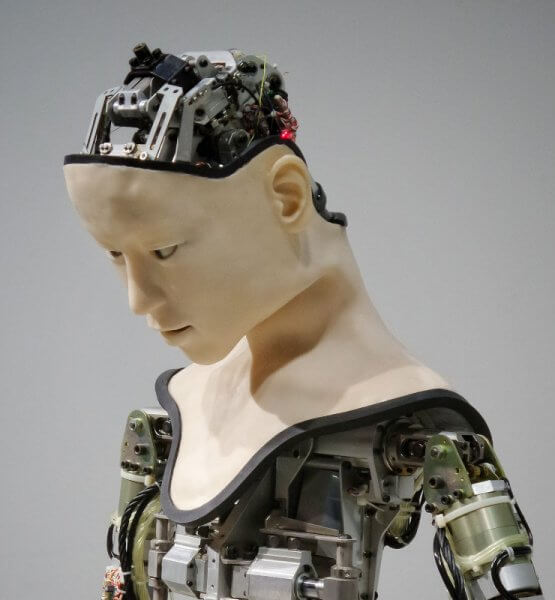

Wie voreingenommen ist Künstliche Intelligenz? Was ist Voreingenommenheit im Bezug auf KIs? Und wieso ist das ein Problem? Wenn jemand voreingenommen ist, hat diese Person ein bestimmtes Bild im Kopf, basierend auf Dingen, die sie bereits gelernt hat. Und so ist es auch bei KIs. Sie fällen Entscheidungen mithilfe der Daten, die sie aus dem Training kennen oder über die Zeit lernen.

Falls ihr euch jetzt fragt, was eine Künstliche Intelligenz überhaupt ist, dann folgt hier eine kleine Definition für euch: Die KI ist der Versuch, menschliches Lernen und Denken auf den Computer zu übertragen und ihm damit Intelligenz zu verleihen. Folglich kann eine KI eigenständig Antworten finden und selbstständig Probleme lösen. Wenn euch das Thema interessiert, könnt ihr euch auch gerne hier mehr dazu durchlesen.

Gorillas statt Menschen: Ist die Künstliche Intelligenz rassistisch voreingenommen gewesen?

Vor einigen Jahren sorgte der Fehler einer KI schon für große Unruhen. Fälschlicherweise klassifizierte die automatische Bilderkennungssoftware von Google das Foto einer Gruppe von Afroamerikanern als „Gorillas“. Dies hat die Öffentlichkeit natürlich verstimmt und als Reaktion auf diese rassistische Einordnung folgten Proteste.

Ihr fragt euch jetzt sicher, wie sowas überhaupt passieren konnte. Hier die Antwort: Das Trainingsmaterial der KI hatte in der Bilddatenbank in der Kategorie „Mensch“ überproportional viele Fotos von hellhäutigen Menschen; von dunkelhäutigen Menschen gab es dagegen nur wenige. Die unzureichende Diversität im Daten-Input war also der Grund für die falsche Einordnung. Die Künstliche Intelligenz war dementsprechend voreingenommen, weil ihr hellhäutige Menschen eher als Repräsentation für die Kategorie Mensch bekannt waren. Wenn man die KI nicht mit so einseitigen Daten entwickelt hätte, wäre dem System so ein Fehler nicht unterlaufen. Aber auch hier gilt, dass die Entwickler aus diesem Fehler lernen konnten, um ihre Software dann im Nachhinein zu optimieren.

Rassistische KIs in der Medizin

Im medizinischen Bereich gibt es mehrere Möglichkeiten KIs einzusetzen – zum Beispiel um Krankheiten frühestmöglich zu erkennen. Aber auch über den weiteren Behandlungsbedarf können KIs schon Entscheidungen treffen. Es hat sich herausgestellt, dass Schwarze einen deutlich schlechteren Gesundheitszustand erleiden mussten als Weiße, um eine intensivere Behandlung bewilligt zu bekommen. Die KI ist somit von einer signifikanten rassenbezogenen Voreingenommenheit geprägt. Wie es dazu kommen konnte? Das US-Gesundheitssystem hatte von Vorherein schon eine strukturelle Ungleichheit zwischen Menschen unterschiedlicher Hautfarbe.

Kriminalität feststellen durch einen Blick aufs Gesicht

Mittlerweile kann man Künstliche Intelligenzen in vielen Bereichen einsetzen, um dem Menschen die Arbeit zu erleichtern. Drei Forscher der Harrisburg University in Pennsylvania haben einem System zum maschinellen Lernen beigebracht, anhand eines Gesichtsfotos zu erkennen, ob jemand kriminell wird. Die US-Forscher berichteten stolz von einer 80 prozentigen Trefferquote. Diese Innovation hat jedoch nicht Alle so begeistert, weshalb die Technik auch nochmal gründlicher untersucht wurde. Hamid Arabina, Informatiker der University of Georgia, war einer der Begutachter. Das System arbeitet mit Daten der Polizei, welche – laut Arabina – ohnehin schon eine Schieflage haben. Das System, das also darüber entscheidet, ob jemand in der Zukunft kriminell wird oder nicht, basiert auf Statistiken. Die KI registriert Bilder von Menschen, die entweder kriminell sind oder nicht und erkennt dabei Eigenschaften, die auf eine Kriminalität hinweisen könnten. Diese Erkenntnis verwertet die KI dann im weiteren Verlauf.

Das grundsätzliche Problem hierbei ist, dass die Daten zur Kriminalität ein falsches Bild vermitteln. So ist es in den USA beispielsweise so, dass People of Color öfter kontrolliert werden, weil sie, wegen rassistischer Vorurteile, als gefährlicher wahrgenommen werden. Im Endeffekt läuft es dann darauf hinaus, dass ein System, welches mit diesen polizeilichen Daten lernt, People of Color krimineller einstuft als Weiße.

Im Bezug auf Rassismus lassen sich noch mehr Beispiele finden, an denen deutlich wird, wie voreingenommen Künstliche Intelligenz sein kann. Es gibt verschiedene Softwareproduckte, die Richtern ihre Entscheidung erleichtern sollen. Wie ihr euch sicherlich denken könnt, ist die KI hier ebenso nicht fehlerfrei und erkennt People of Color als größeres Risiko bzw. als „schuldiger“ an.

Sexistische KIs? Leider ja.

Es ist nichts Neues, dass die Geschlechter auch noch in der heutigen Zeit ungleich behandelt werden. Man könnte dann doch annehmen, dass wenn eine KI die Entscheidung fällen soll, keine Ungerechtigkeit gegenüber Frauen aufkommt. Falsch gedacht, wie in diesem Beitrag des ZDF eindrucksvoll gezeigt wird!

Kann man die Voreingenommenheit bei Künstlichen Intelligenzen beseitigen?

Die Informatiker und auch die KI-Communities sind sich des Problems natürlich bewusst und arbeiten auch schon an einer Lösung. So planen Unternehmen wie z.B. Microsoft und Google, ihre eigenen ethischen Richtlinien für die KI zu entwickeln. Manko der ganzen Sache ist, dass die kulturellen und sozialen Nuancen, die unterschiedliche Interpretationen von ethischem Verhalten prägen, bisher nicht richtig erfasst und widergespiegelt werden können.

Ziel ist es demnach in der Zukunft, dafür zu sorgen, dass man bei der Entwicklung von KIs kontextuelle und wahrnehmungsbezogene Unterschiede mehr berücksichtigt und dadurch die Effizienz der Algorithmen insgesamt zu verbessern. Zudem soll man den neuen KI-Modellen eine gewisse Dynamik überlassen, damit sie sich im Zuge des kulturellen und sozialen Wandels weiterentwickeln können.

Wann dieses Vorhaben vollkommen umgesetzt und optimiert wird, ist noch unklar, aber die Absichten dahinter sind super und werden den Wert der KI mit Sicherheit fördern und uns in der Forschung voranbringen.

Foto von Franck V. via Unsplash

Artikel per E-Mail verschicken

Schlagwörter: Digitale Ethik, Künstliche Intelligenz, Rassismus